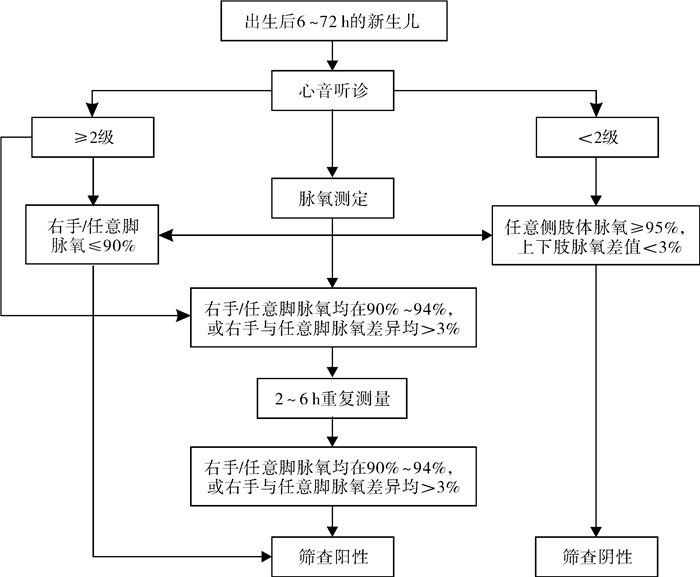

先天性心脏病(congenital heart disease, CHD)是常见的出生缺陷之一,占活产儿1.00%~1.20%,在新生儿非感染性疾病中病死率居首位,如不经治疗,约1/3的患儿在6~12月龄死亡[1]。随着人们对CHD认识的加深和筛查手段的不断进步,CHD患儿已能够在早期得到诊治。随着CHD筛查纳入我国先天性出生缺陷筛查谱,并在全国推广双指标方案(图 1),CHD筛查诊治工作得以全面展开[2]。目前双指标方案中脉氧测定已有成熟的商用设备,而心脏听诊则需检查者通过听诊器进行主观经验判断,受个人经验和外界因素的影响较大,易出现误诊、漏诊等情况。以心音听诊为代表的依据心音强度、杂音等相关信息判断心脏畸变和评估心脏功能分级的基础决策方法目前仍面临较大的困难与挑战[3]。

|

图 1 新生儿先天性心脏病双指标筛查方案 Fig.1 Dual-indicator screening program for neonatal congenital heart disease |

近年来,随着现代信息技术的发展及心脏多普勒彩色超声、心电图等无创检测的广泛应用,以及机器学习(machine learning, ML)、人工神经网络(artificial neural network, ANN)、卷积神经网络(convolutional neural networks, CNN)、深度学习(deep learning, DL)等人工智能(artificial intelligence, AI)技术的日趋成熟,CHD心音智能听诊技术成为可能[4-5]。通过智能系统模拟大脑思维运行模式,以获得记忆及决策能力的AI技术,已成为现代科技在医疗领域中的研究热点[4]。AI听诊技术主要涉及心音信号的去噪、分段、特征提取和分类识别等环节[6-7]。本文就目前阶段AI听诊技术的研究现状进行综述,总结近年来基于DL的智能听诊技术在CHD领域的发展,并提出心音听诊在临床应用中亟待解决的问题。

一、心音与心脏杂音心音是由心脏瓣膜的启闭、心肌的收缩和舒张、血流的冲击以及心血管壁的振动所产生的复合音,这些音频信号可以被记录为心音图(phonocardiography, PCG)[6]。PCG具有准周期性,每个心音信号的周期称为心动周期。根据心动周期中心音的出现顺序,心音被分为四个阶段:第一心音(sound 1, S1)、第二心音(sound 2, S2)、第三心音(sound 3, S3)和第四心音(sound 4, S4)。S1发生在心脏收缩期的开始,其音调低沉且持续时间较长(频率50~100 Hz,持续时间50~100 ms),产生的原因包括心室肌收缩、房室瓣关闭以及射血入主动脉等引起的振动;而S2发生在心脏舒张期的开始,其频率较高且持续时间较短(频率50~200 Hz,持续时间25~50 ms),产生的原因包括主/肺动脉瓣瓣膜关闭、大动脉中血液减速和心室内压迅速下降引起的振动[8]。S1和S2较易闻及,并常作为心音分段的定位基础[9]。同一心音图中S1和S2之间的时期被称为收缩期,下一个周期中S2和S1之间的时期被称为舒张期。一个完整的心动周期约0.80 s,其中正常收缩期约0.35 s,舒张期约0.45 s,这些数值变化与心血管疾病的病理生理改变密切相关[10]。

心脏杂音是由心脏或血管内产生湍流而引起的非心音性振动,在心脏收缩或舒张时产生,表现为一组历时较长、频率不同、振幅不同的异常声音[4]。这些杂音的强度、频率和质量特征反映了心脏瓣膜、心肌功能和心内血流状况,其产生机制与心血管疾病密切相关,心脏杂音的识别判断在CHD早期筛查中至关重要[10]。传统心音听诊是一种完全基于主观经验的判断方法,受听诊者和环境的影响较大,易出现误诊、漏诊。随着AI技术在医疗领域的广泛应用,AI听诊技术通过分析心音以获得量化的特征参数,有助于发现心音与心血管疾病之间的关系[6, 8, 10]。

二、人工智能心音听诊技术AI辅助检测技术具有快速、高效、经济的特点,可用于心音信号的定量分析,通过提取PCG中的关键参数,以获得更直观的诊断结果,并进一步推断出潜在的心血管疾病类型[10]。AI心音听诊技术主要涉及心音信号的去噪、分段、特征提取和分类识别[6-7]。

(一) 心音去噪受外部环境影响,心音数字化信号在临床收集过程中会与电磁干扰、随机噪声、呼吸音、肺音等耦合,心音听诊智能诊断的准确度受到信号采集质量和提取特征的双重影响[11]。因此,对心音信号分析之前需要进行必要的降噪处理,目前研究和应用较广的心音降噪方式包括离散小波变换(discrete wavelet transform, DWT)、经验模式分解(empirical mode decomposition, EMD)、奇异值分解(singular value decomposition, SVD)等方法[11-14]。

为获得更好的降噪效果,心音信号在降噪处理中常采用组合方法,以提高心音信号的质量和检测精度。Mondal等[11]提出了一种基于DWT和SVD相结合的心音降噪方法;Zheng等[15]提出了一种基于改进SVD和压缩感知(compressed sensing, CS)相结合的创新去噪框架,与传统技术(DWT、EMD)相比,该框架具有更大的信噪比,同时保留了去噪后心音信号与原始心音信号之间的高相关性。

部分干扰信号(肺音、环境声)可能与心音信号存在较为明显的频率混叠现象,导致基于信号频率分解的降噪方法难以适用于心音去噪处理,这极大影响了后续CHD心音特征的提取。为解决这一问题,Shah等[16]将单通道混合心音信号的时频谱进行非负矩阵分解(nonnegative matrix factorization, NMF),根据心音自身信号成分的相关性,并结合聚类方法,对NMF的基矩阵和系数矩阵进行区分,得到分别属于心音的部分,最后经信号重构得到源信号,从而实现心音的降噪提取。

(二) 心音分段心音分段作为心音分类特征工作的前提,以确定心音信号中S1、收缩期、S2以及舒张期4个状态的位置区间。心音分段有利于从各心音状态中分别提取心杂音的特性,从而借助杂音中丰富的病理信息进行CHD的分析和诊断。对此,国内外学者提出了大量的心音分段方法,表 1总结了部分近年来心音信号分段的相关文献[17-22]。

| 表 1 心音信号的分段方法 Table 1 Segmentation methods for heart sound signals |

|

|

在对心音进行分类之前,需从分段的心音信号中提取少量具有代表性的心音类别特征来代替高维原始信号[7]。总的来说,与基于原始信号训练的分类模型相比,基于特征训练的分类模型更高效、准确,在心音智能诊断方面取得了一系列成果。常用的心音特征提取方法包括:DWT、连续小波变换(continuous wavelet transformation, CWT)、短时傅立叶变换(short-time fourier transform, STFT)、梅尔倒频谱系数(mel-frequency cepstral coefficient, MFCC)和变分模态分解(variational mode decomposition, VMD)等[23-25]。

在提取心音特征参数之后,心音分类算法会依据特征参数对心音进行分类,从而实现CHD的筛查和辅助诊断。分类问题通常采用二分类、多重分类和回归等方法,分类任务的选择也会在一定程度上影响分类结果[26]。根据机器学习(machine learning, ML)算法的原理,心音分类算法可分为基于传统机器学习的分类算法和基于DL的分类算法两大类[27-28]。基于传统机器学习的分类算法允许计算机系统有效地访问和分析数据,通过人工设计心音有效特征,并根据模式和经验对算法功能进行调整和改进,不需要显式编程。目前常用的分类算法包括:支持向量机(support vector machine, SVM)、随机森林(random forest, RF)、决策树、MFCC等算法模型。Deng等[29]利用DWT对心音信号子带系数进行计算,得到信号的包络,随后从信号包络信息中提取相关特征并进行融合,得到具有扩散映射的统一特征参数,最后将特征参数输入SVM中,完成心音分类任务。Yaseen等[30]提出采用MFCC特征结合DWT特征实现心音分类任务,同时比较SVM、基于质心位移的K邻近算法和深度神经网络(deep neutral networks, DNN)在心音分类任务中的性能,结果显示SVM的平均准确率达97.90%,具备最优分类性能。

基于传统机器学习算法的有效性取决于人为选定的心音特征,心音特征参数的选择将直接影响心音分类算法的性能。然而,不同病理条件下心音信号具有多样性,给心音信号特征参数的筛查和选择带来了重重困难,使得基于传统机器学习的分类算法在进一步优化时面临巨大挑战[27]。随着CHD筛查方案的不断推进和心血管疾病发病率的上升,心音数据的处理量也在逐渐增加。在处理大量临床数据并进行分析的同时,为了保证数据处理准确性和满足分类需求,DL算法被逐渐应用于心音分类诊断的任务中[19, 31-32]。

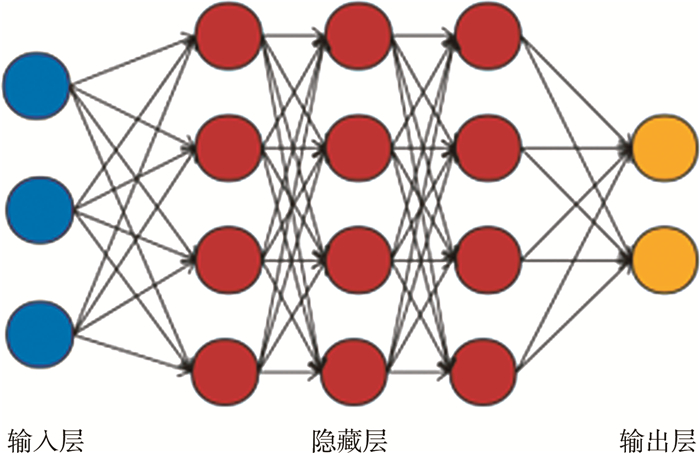

三、深度学习在心音分类中的发展和应用DL技术是应用神经网络机器学习技术的总称,通过比传统机器学习更深入的学习,逐层搭建神经网络,形成多层次、多维度的深度神经学习网络,让机器自主地从数据库或数据集中识别、提取、表达出隐含在数据内部、更加本质的数据特征,从而提高分类的准确性和效率(图 2)[32]。2006年,Hinton等[33]首次提出DL的概念,其利用空间的相对关系,将低层模型结合起来形成更复杂的高层模型,大大提高了系统训练性能。近年来,DL算法在图像识别、生物医学数据分析、信号处理等领域表现出良好的实用性和可靠性。DL模型已经应用于心音信号的分类,模型主要包括DNN、卷积神经网络(convolutional neural network, CNN)、循环神经网络(recurrent neural network, RNN)、长短期记忆网络(long short term memory, LSTM)等[27, 32, 34]。

|

图 2 深度学习原理图 Fig.2 Schematic diagram of deep learning |

基于DL的分类算法是指针对心音波形图或时频域特征、人工设计特征并结合深度神经网络自动提取更加高级、抽象的特征,最终实现心音分类。与传统的心音分类算法相比,DL技术避免了人工干预、过程复杂、泛化能力差的问题[26]。Potes等[28]提取了心音信号的124个时频域特征,并利用AdaBoost分类器对这些特征进行分类,此外还提取了4个频带的信号,将其输入一维CNN进行分类,两者共同决策分类,灵敏度和特异度分别为94.24%和77.81%。Oh等[35]采用新型深度波网络模型在心音数据集上执行五元组分类任务(正常、主动脉瓣狭窄、二尖瓣反流、二尖瓣脱垂和二尖瓣狭窄),准确率达97.00%,对正常心音分类的准确率达98.20%。

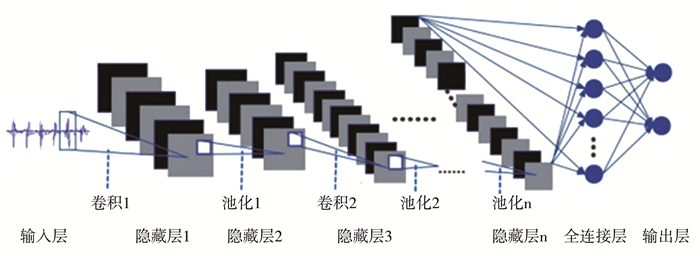

在诸多人工神经网络模型中,CNN模型将原始数据转换为二维矩阵格式,在提取图像特征值方面优于传统的人工神经网络[26]。得益于其所采用的卷积、池化等操作,CNN模型可通过堆叠多个卷积层和池化层,从而构建深层CNN模型,在计算机视觉任务(图像、视频数据)中可获得卓越性能(图 3)[36-38]。Kui等[37]结合对数梅尔频谱系数(log mel-frequency spectral coefficients, L-MFSC)和CNN进行心音分类,该方法的二分类正确率为93.89%,多分类正确率为86.25%。Krishnan等[38]使用一维CNN和前馈神经网络对原始心音信号进行分类,其分类准确率为85.70%。Li等[39]通过降噪自动编码器提取心音特征,并将一维CNN作为分类器,分类准确率达99.00%。然而,该研究在对原始数据集进行扩展时,心音信号同时进入测试集和验证集,使得其分类准确率存在偏高的可能性,不符合临床实际应用需求。在研究不同DL模型用于心音智能诊断和分类中,Deng等[36]采用MFCC特征结合一阶和二阶差分特征作为网络输入,并对比不同网络模型,结果显示CNN模型具有最优分类准确率(98.34%)。

|

图 3 深层卷积神经网络原理图 Fig.3 Schematic diagram of deep convolutional neural network |

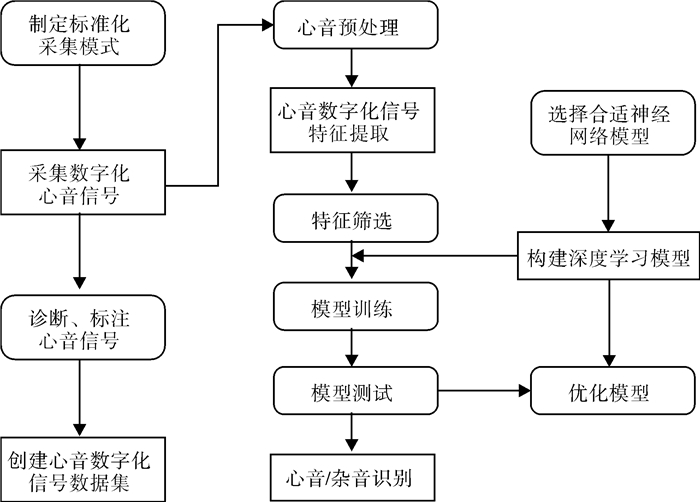

目前基于DL在CHD心音听诊中的诊断技术已有较多研究,但大部分仍处于算法研究阶段,且基于特定数据集实现,较少在临床得到验证。心音智能听诊技术利用DL能够高效地辨识心脏音频信号异常,如心脏杂音和心律失常,为医师提供辅助诊断信息,其技术路线见图 4。Xiao等[40]构建了一个包含137名受试者、528个高质量心音记录的儿科心音数据集,并利用两个轻量级CNN模型开发了基于DL的儿童CHD计算机辅助诊断系统。Xu等[41]建立了一个包含941个心音信号的儿童CHD心音数据库,并在此基础上采用基于随机森林的分类器和Adboost分类器,实现了CHD的准确分类。结果表明,该方法对CHD分类的灵敏度、特异度以及调和平均分数分别为94.60%、96.10%和95.30%。

|

图 4 基于深度学习的智能听诊技术路线 Fig.4 Technical route of intelligent auscultation based on deep learning |

在CHD智能听诊辅助诊断方面,Aziz等[27]为实现正常心音、房间隔缺损(atrial septal defect, ASD)和室间隔缺损(ventricular septal defect, VSD)的三分类,提出针对心音数字化信号提取MFCC特征,并结合一维局部三元模式(one-dimensional local ternary patterns, 1D-LTP)特征,实现了CHD三分类任务,并通过SVM进行模型训练,最终平均准确率达95.24%。Zhu等[42]采用线性预测倒谱系数(linear predictive cepstral coefficients, LPCC)特征和MFCC特征对心音进行分析和特征提取,并通过反向传播神经网络进行分类任务,最终结果显示MFCC特征(特异度93.02%,灵敏度88.89%)优于LPCC特征(特异度86.96%,灵敏度86.96%)。

结合互联网技术的心音智能听诊设备实现了心脏音频信号的远程传输和监测,对长期监测心功能的患者具有重要意义。Chowdhury等[43]提出了一种智能数字听诊器系统的原型模型,用于监测患者的心音并实时诊断异常,通过捕获患者的心音,并无线传输到个人计算机,实现心音正常和异常的二分类。测试调整后的优化集成算法对异常和正常心音的分类准确率分别为97%和88%。

心音智能听诊技术可用于医学教育和培训,帮助医学生和医师学习和熟悉心脏音频信号的特征和诊断方法。听诊依赖于医师的主观经验,不同医师在听诊诊断上存在较大差异,基层医疗单位缺乏高级心脏病专家和年轻实习生缺乏听诊能力,限制了听诊筛查在CHD中的推广和应用[44]。通过智能听诊设备和教学软件,医学生和医师可以进行虚拟听诊和模拟诊断,提高听诊技巧和诊断能力。因此,开发计算机辅助听诊算法和系统不仅是实现CHD筛查和诊断的有效途径,也可用于回顾性教学和临床教学。

五、先天性心脏病智能听诊面临的问题和挑战虽然心音智能听诊在医疗领域有着广阔的应用前景,但目前仍然存在一些挑战和限制。随着AI技术的不断发展和成熟,心音智能听诊技术有望为心脏疾病的筛查、诊断和监测提供更加准确和便捷的方法。在心音预处理和数据集问题方面,心音信号采集受到多种干扰,包括环境噪音、采集设备噪音以及其他器官的干扰。常用降噪技术(DWT、EMD等)难以精确区分心音信号和噪音,因此设计出精准区分心音和噪音的自适应阈值函数具有一定的挑战性,仅通过空间变换和线性滤波处理往往难以完全分离心音和噪音,且容易导致心音失真[11-13]。此外,在心音分类方法中,心音分段是特征提取与分类的基础。然而,由于异常心音受到病理性杂音和噪音的严重干扰,难以准确划分心动周期,部分研究者采用截取固定时长的心音片段为研究对象,而另一些则采用不定时长的原始心音序列[28, 31]。这种时序信息结构缺乏的分段方式易导致不同片段或序列的起始时刻不一致,进而干扰特征提取与心动周期结构的匹配,影响识别性能。

DL模型的训练需要大量特征参数和标签样本数据,但数据量不足或分布不一致可能会导致算法性能下降。国内外团队为进行心音智能AI算法的开发和验证创建了多个心音信号数据集,其准确率达90%以上[20, 41, 45]。然而,现有心音信号数据集普遍存在采集方式不规范、信号数据样本少、标注标签缺乏、未进行降噪预处理等情况,算法在临床实践中的普适性和稳定性有待进一步验证。目前,缺乏标准化、高质量且标签完备的心音音频数据库已成为心音智能听诊算法优化改进的最大阻碍。为了解决这一问题,还需要进一步建立标准化的心音数据库,并组织专家达成共识,以规范心音信号采集流程、统一采集设备、明确数据库架构以及信号特征参数,从而提高心脏疾病筛查、诊断和监测水平,促进AI辅助听诊系统的建立和完善。

在心音算法和模型构建问题方面,现有的算法和模型主要针对成人心脏瓣膜和大血管疾病。此外,DL模型的构建需要大量的计算资源,特别是需要强大的中央处理单元(central processing unit, CPU)和图形处理单元(graphics processing unit, GPU)来执行计算,未来研究还需集中在优化DL模型结构、减少心音特征参数提取数量、提高算法和模型的泛化性以及开发更加有效的训练方法和利用迁移学习技术等方面[10]。

DL模型通过误差反向传播以实现参数的优化,使得其在临床应用中难以解释输出的诊断结果与输入数据之间的关联性或因果关系,无法提供诊断依据和病因病理说明,输出的心音分类结果缺乏可解释性,不易被医师信任和采纳。因此,为实现模型的临床应用,寻求模型可解释性也是现阶段DL技术面临的挑战。心音决策系统的开发需要跨学科的合作,涉及医学、工程学、计算机科学等多个领域,这些问题的解决还需要科研人员、临床医师和工程师之间的密切合作,促进跨学科的协同工作,以推动心音听诊辅助诊断系统更广泛地服务于医疗领域。

六、小结随着AI技术的不断发展,智能化心血管疾病听诊辅助诊断技术变得可能。近年来,基于DL的AI听诊技术在CHD领域得到了广泛的研究和应用,但这些技术在临床实践中仍面临诸多挑战和不确定性。尽管AI听诊技术在理论上表现出了相当的潜力,但其在临床环境中的有效性和可靠性尚未得到充分验证。这种AI听诊技术在临床应用中的实用性、一致性和可解释性等方面仍存在不足,这也导致了智能心音听诊缺乏成熟的商用产品,难以在临床CHD筛查中得到广泛应用。为解决这一问题,相关医疗机构应组织专家共同制定CHD心音听诊筛查的共识和标准化流程,并在此基础上建立起完备的儿童CHD心音数据库,以支持后续研究和开发工作。同时,为了进一步提高智能听诊技术的性能和可靠性,相关研究机构需要进一步改进和优化心音分类算法,提高心音分类模型输入与输出结果之间的可解释性,以便医护人员能够做出正确的临床判断。

利益冲突 所有作者声明不存在利益冲突

| [1] |

Pierpont ME, Brueckner M, Chung WK, et al. Genetic basis for congenital heart disease: revisited: a scientific statement from the American Heart Association[J]. Circulation, 2018, 138(21): e653-e711. DOI:10.1161/cir.0000000000000606 |

| [2] |

Zhao QM, Ma XJ, Ge XL, et al. Pulse oximetry with clinical assessment to screen for congenital heart disease in neonates in China: a prospective study[J]. Lancet, 2014, 384(9945): 747-754. DOI:10.1016/s0140-6736(14)60198-7 |

| [3] |

Bengio Y, Courville A, Vincent P. Representation learning: a review and new perspectives[J]. IEEE Trans Pattern Anal Mach Intell, 2013, 35(8): 1798-1828. DOI:10.1109/tpami.2013.50 |

| [4] |

Clifford GD, Liu CY, Moody B, et al. Recent advances in heart sound analysis[J]. Physiol Meas, 2017, 38(8): E10-E25. DOI:10.1088/1361-6579/aa7ec8 |

| [5] |

Cheng JW, Sun KX. Heart sound classification network based on convolution and transformer[J]. Sensors (Basel), 2023, 23(19): 8168. DOI:10.3390/s23198168 |

| [6] |

Bozkurt B, Germanakis I, Stylianou Y. A study of time-frequency features for CNN-based automatic heart sound classification for pathology detection[J]. Comput Biol Med, 2018, 100: 132-143. DOI:10.1016/j.compbiomed.2018.06.026 |

| [7] |

Chakir F, Jilbab A, Nacir C, et al. Phonocardiogram signals processing approach for PASCAL Classifying Heart Sounds Challenge[J]. Signal Image Video Process, 2018, 12(6): 1149-1155. DOI:10.1007/s11760-018-1261-5 |

| [8] |

Cheng XF, Zhang Z. Denoising method of heart sound signals based on self-construct heart sound wavelet[J]. AIP Adv, 2014, 4(8): 087108. DOI:10.1063/1.4891822 |

| [9] |

Abdollahpur M, Ghaffari A, Ghiasi S, et al. Detection of pathological heart sounds[J]. Physiol Meas, 2017, 38(8): 1616-1630. DOI:10.1088/1361-6579/aa7840 |

| [10] |

Li SY, Li F, Tang SJ, et al. A review of computer-aided heart sound detection techniques[J]. Biomed Res Int, 2020, 2020: 5846191. DOI:10.1155/2020/5846191 |

| [11] |

Mondal A, Saxena I, Tang H, et al. A noise reduction technique based on nonlinear kernel function for heart sound analysis[J]. IEEE J Biomed Health Inform, 2018, 22(3): 775-784. DOI:10.1109/jbhi.2017.2667685 |

| [12] |

Gradolewski D, Magenes G, Johansson S, et al. A wavelet transform-based neural network denoising algorithm for mobile phonocardiography[J]. Sensors (Basel), 2019, 19(4): 957. DOI:10.3390/s19040957 |

| [13] |

Ali MN, El-Dahshan ESA, Yahia AH. Denoising of heart sound signals using discrete wavelet transform[J]. Circuits Syst Signal Process, 2017, 36(11): 4482-4497. DOI:10.1007/s00034-017-0524-7 |

| [14] |

Vican I, Kreković G, Jambrošić K. Can empirical mode decomposition improve heartbeat detection in fetal phonocardiography signals?[J]. Comput Methods Programs Biomed, 2021, 203: 106038. DOI:10.1016/j.cmpb.2021.106038 |

| [15] |

Zheng YN, Guo XM, Jiang H, et al. An innovative multi-level singular value decomposition and compressed sensing based framework for noise removal from heart sounds[J]. Biomed Signal Process Control, 2017, 38: 34-43. DOI:10.1016/j.bspc.2017.04.005 |

| [16] |

Shah G, Koch P, Papadias CB. On the blind recovery of cardiac and respiratory sounds[J]. IEEE J Biomed Health Inform, 2015, 19(1): 151-157. DOI:10.1109/jbhi.2014.2349156 |

| [17] |

Guo Y, Yang HB, Guo T, et al. A novel heart sound segmentation algorithm via multi-feature input and neural network with attention mechanism[J]. Biomed Phys Eng Express, 2022, 9(1): 015012. DOI:10.1088/2057-1976/ac9da6 |

| [18] |

Fernando T, Ghaemmaghami H, Denman S, et al. Heart sound segmentation using bidirectional LSTMs with attention[J]. IEEE J Biomed Health Inform, 2020, 24(6): 1601-1609. DOI:10.1109/jbhi.2019.2949516 |

| [19] |

Renna F, Oliveira J, Coimbra MT. Deep convolutional neural networks for heart sound segmentation[J]. IEEE J Biomed Health Inform, 2019, 23(6): 2435-2445. DOI:10.1109/jbhi.2019.2894222 |

| [20] |

Nivitha Varghees V, Ramachandran KI. Effective heart sound segmentation and murmur classification using empirical wavelet transform and instantaneous phase for electronic stethoscope[J]. IEEE Sens J, 2017, 17(12): 3861-3872. DOI:10.1109/jsen.2017.2694970 |

| [21] |

Springer DB, Tarassenko L, Clifford GD. Logistic regression-HSMM-based heart sound segmentation[J]. IEEE Trans Biomed Eng, 2016, 63(4): 822-832. DOI:10.1109/tbme.2015.2475278 |

| [22] |

Papadaniil CD, Hadjileontiadis LJ. Efficient heart sound segmentation and extraction using ensemble empirical mode decomposition and kurtosis features[J]. IEEE J Biomed Health Inform, 2014, 18(4): 1138-1152. DOI:10.1109/jbhi.2013.2294399 |

| [23] |

Zeng W, Yuan J, Yuan CZ, et al. A new approach for the detection of abnormal heart sound signals using TQWT, VMD and neural networks[J]. Artif Intell Rev, 2021, 54(3): 1613-1647. DOI:10.1007/s10462-020-09875-w |

| [24] |

Kay E, Agarwal A. DropConnected neural networks trained on time-frequency and inter-beat features for classifying heart sounds[J]. Physiol Meas, 2017, 38(8): 1645-1657. DOI:10.1088/1361-6579/aa6a3d |

| [25] |

Nogueira DM, Ferreira CA, Gomes EF, et al. Classifying heart sounds using images of motifs, MFCC and temporal features[J]. J Med Syst, 2019, 43(6): 168. DOI:10.1007/s10916-019-1286-5 |

| [26] |

Li F, Zhang Z, Wang LL, et al. Heart sound classification based on improved Mel-frequency spectral coefficients and deep residual learning[J]. Front Physiol, 2022, 13: 1084420. DOI:10.3389/fphys.2022.1084420 |

| [27] |

Aziz S, Khan MU, Alhaisoni M, et al. Phonocardiogram signal processing for automatic diagnosis of congenital heart disorders through fusion of temporal and cepstral features[J]. Sensors (Basel), 2020, 20(13): 3790. DOI:10.3390/s20133790 |

| [28] |

Potes C, Parvaneh S, Rahman A, et al. Ensemble of feature-based and deep learning-based classifiers for detection of abnormal heart sounds[J]. Comput Cardiol, 2016, 43: 621-624. DOI:10.22489/CinC.2016.182-399 |

| [29] |

Deng SW, Han JQ. Towards heart sound classification without segmentation via autocorrelation feature and diffusion maps[J]. Future Gener Comput Syst, 2016, 60: 13-21. DOI:10.1016/j.future.2016.01.010 |

| [30] |

Yaseen, Son GY, Kwon S. Classification of heart sound signal using multiple features[J]. Appl Sci, 2018, 8(12): 2344. DOI:10.3390/app8122344 |

| [31] |

Dominguez-Morales JP, Jimenez-Fernandez AF, Dominguez-Mora-les MJ, et al. Deep neural networks for the recognition and classification of heart murmurs using neuromorphic auditory sensors[J]. IEEE Trans Biomed Circuits Syst, 2018, 12(1): 24-34. DOI:10.1109/tbcas.2017.2751545 |

| [32] |

Chen W, Sun Q, Chen XM, et al. Deep learning methods for heart sounds classification: a systematic review[J]. Entropy (Basel), 2021, 23(6): 667. DOI:10.3390/e23060667 |

| [33] |

Hinton G, Osindero S, Welling M, et al. Unsupervised discovery of nonlinear structure using contrastive backpropagation[J]. Cogn Sci, 2006, 30(4): 725-731. DOI:10.1207/s15516709cog0000_76 |

| [34] |

Huai XM, Kitada S, Choi D, et al. Heart sound recognition technology based on convolutional neural network[J]. Inform Health Soc Care, 2021, 46(3): 320-332. DOI:10.1080/17538157.2021.1893736 |

| [35] |

Oh SL, Jahmunah V, Ooi CP, et al. Classification of heart sound signals using a novel deep WaveNet model[J]. Comput Methods Programs Biomed, 2020, 196: 105604. DOI:10.1016/j.cmpb.2020.105604 |

| [36] |

Deng MQ, Meng TT, Cao JW, et al. Heart sound classification ba-sed on improved MFCC features and convolutional recurrent neural networks[J]. Neural Netw, 2020, 130: 22-32. DOI:10.1016/j.neunet.2020.06.015 |

| [37] |

Kui HR, Pan JH, Zong R, et al. Heart sound classification based on log Mel-frequency spectral coefficients features and convolutional neural networks[J]. Biomed Signal Process Control, 2021, 69: 102893. DOI:10.1016/j.bspc.2021.102893 |

| [38] |

Krishnan PT, Balasubramanian P, Umapathy S. Automated heart sound classification system from unsegmented phonocardiogram (PCG) using deep neural network[J]. Phys Eng Sci Med, 2020, 43(2): 505-515. DOI:10.1007/s13246-020-00851-w |

| [39] |

Li F, Liu M, Zhao YJ, et al. Feature extraction and classification of heart sound using 1D convolutional neural networks[J]. EURASIP J Adv Signal Process, 2019, 2019(1): 59. DOI:10.1186/s13634-019-0651-3 |

| [40] |

Xiao B, Xu YQ, Bi XL, et al. Follow the sound of children's heart: a deep-learning-based computer-aided pediatric CHDs diagnosis system[J]. IEEE Internet Things J, 2020, 7(3): 1994-2004. DOI:10.1109/jiot.2019.2961132 |

| [41] |

Xu WZ, Yu K, Ye JJ, et al. Automatic pediatric congenital heart disease classification based on heart sound signal[J]. Artif Intell Med, 2022, 126: 102257. DOI:10.1016/j.artmed.2022.102257 |

| [42] |

Zhu LL, Pan JH, Shi JH, et al. Research on recognition of CHD heart sound using MFCC and LPCC[J]. J Phys Conf Ser, 2019, 1169(1): 012011. DOI:10.1088/1742-6596/1169/1/012011 |

| [43] |

Chowdhury MEH, Khandakar A, Alzoubi K, et al. Real-time sma-rt-digital stethoscope system for heart diseases monitoring[J]. Sensors (Basel), 2019, 19(12): 2781. DOI:10.3390/s19122781 |

| [44] |

Leng S, Tan RS, Chai KTC, et al. The electronic stethoscope[J]. Biomed Eng Online, 2015, 14(1): 66. DOI:10.1186/s12938-015-0056-y |

| [45] |

Sun SP, Jiang ZW, Wang HB, et al. Automatic moment segmentation and peak detection analysis of heart sound pattern via short-time modified Hilbert transform[J]. Comput Methods Programs Biomed, 2014, 114(3): 219-230. DOI:10.1016/j.cmpb.2014.02.004 |

2024, Vol. 23

2024, Vol. 23